论文笔记——RMBERT: News Recommendation via Recurrent Reasoning Memory Network over BERT

RMBERT: News Recommendation via Recurrent Reasoning Memory Network over BERT

论文概况

https://dl.acm.org/doi/abs/10.1145/3404835.3463234

SIGIR ‘21: Proceedings of the 44th International ACM SIGIR Conference on Research and Development in Information Retrieval

July 2021 Pages 1773–1777

https://doi.org/10.1145/3404835.3463234

摘要

现有的方法大多是根据新闻内容将每个用户和新闻分别编码为向量,然后对两个向量进行匹配。但是,用户对每个新闻或新闻的每个主题的兴趣可能是不同的。动态地学习用户和新闻向量,并对他们的互动进行建模是必要的。

在本研究中,我们提出了基于BERT的循环推理记忆网络(RMBERT)用于新闻推荐。与其他方法相比,我们的方法可以利用BERT的内容建模能力。此外,循环推理记忆网络执行一系列基于注意力的推理步骤,可以动态学习用户和新闻向量,并对每一步的交互进行建模。因此,我们的方法可以更好地模拟用户的兴趣。我们在真实世界的新闻推荐数据集上进行了广泛的实验,结果表明,我们的方法显著优于现有的最先进的方法。

1 引言

最近,一些方法探索使用神经网络以端到端方式学习新闻和用户表示,并在训练过程中优化这些表示。DKN [13], NPA [15], LSTUR[1]提出使用CNN学习新闻表示,然后将候选新闻与用户点击的新闻进行匹配。DKN将知识图表示引入新闻推荐。NPA通过嵌入用户ID来关注重要词汇和新闻,增强了新闻和用户表示。LSTUR结合了长期和短期用户表示,以更精确地对用户进行建模。NRMS[16]引入多头自我注意学习新闻表示。FIM[12]通过叠加扩张卷积提取每个新闻的多层表示。

在新闻推荐场景中有两个常见的观察结果。首先,不同的用户可能对候选人新闻的不同部分感兴趣。第二,用户的兴趣通常是多样化的,用户历史中不同的新闻代表了该用户的不同兴趣。以前的工作 [9, 13, 16] 使用一个固定的嵌入向量来表示用户和新闻,这可能会限制模型的表达能力。作为一个解决方案,我们需要动态地确定关于候选新闻的用户向量。记忆网络能够捕获两个对象之间的高阶复杂关系,在问题回答[4,7]、情感分析[11]、机器理解[10]等领域都取得了很大的进展。受其成功的激励,我们设计了一个循环结构的迭代推理过程,多个推理记忆单元(RMC)级联执行结构化推理操作,一步一步确定匹配分数。

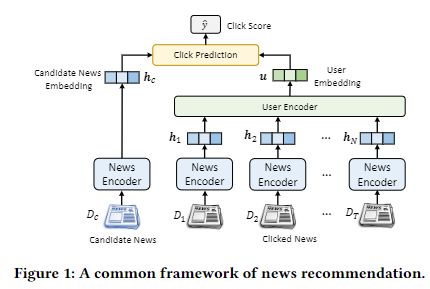

我们的方法的体系结构如图1所示。

- 新闻编码器模块通过处理每个新闻的标题并生成新闻嵌入来提取候选新闻和一些用户点击的新闻。

- 在此之后,循环推理记忆网络中包含一些以新闻嵌入为输入的rmc,它们协同工作,逐级执行推理过程。在每一步中,RMC通过查询单元和存储单元进行推理操作。查询单元使用注意机制来选择用户可能感兴趣的候选新闻嵌入的某些方面来更新查询状态。所述存储单元根据查询状态,从用户点击的新闻嵌入中动态检索用户的兴趣。经过几个推理步骤后,RMBERT可以从多个方面捕获用户对候选新闻的偏好。

- 最后,我们根据最后的存储状态来推荐新闻,该状态包含了用户和候选新闻之间的交互信息。

这项工作的主要贡献总结如下。

- 我们使用BERT对候选新闻和用户点击新闻进行独立编码。我们的方法可以利用BERT的表达能力,同时获得离线预计算新闻嵌入的能力。

- 我们提出了一种循环结构来逐步执行基于注意力的推理操作。 在每个步骤中,RMC 可以推断候选新闻的某些部分与用户兴趣之间的匹配分数。 RMC可以在每一步动态确定新闻和用户向量,并在多方面探索它们的匹配。

- 从MSN新闻收集的真实数据集上进行的大量实验证实,我们的方法比现有的最先进的方法具有更好的性能。

Leeshy's Blog

Leeshy's Blog